Alain Caupène 2021

En cours de rédaction

Une étincelle de génie

Il a fallu attendre la fin du XIXe siècle pour que l’on s’aperçoive de l’existence des ondes électromagnétiques, les ondes radio.

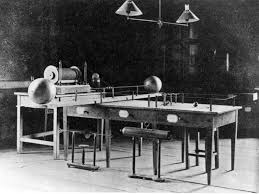

C’est seulement lors de l’expérience célèbre des « boucles de Hertz » en 1887, qu’Heinrich Hertz a pu mettre en évidence des « ondes » qui avaient été prédites en 1864 par James Clerk Maxwell. Ces ondes ont été plus tard appelées « ondes hertziennes ».

Heinrich Hertz et son laboratoire

Bien entendu, si l’électricité avait été décrite depuis l’Antiquité, la notion de circuit électrique est plus récente. En effet on connaissait depuis longtemps l’électricité statique et ses conséquences mais pas les propriétés du circuit électrique et ses applications pratiques. Pour cela il a fallu attendre le début du XIXe siècle avec les grands savants tels qu’Ampère puis les années 1850 pour voir arriver des innovations telles que l’éclairage ou le télégraphe électrique. Le télégraphe Morse est un modèle parmi d’autres mais c’est le seul à avoir été aussi développé. C’est à cette époque que toutes les découvertes majeures concernant le courant électrique ont été faites.

Hertz, qui connaissait la nature ondulatoire de l’étincelle électrique, a fait un rapprochement avec les ondes acoustiques et le phénomène de résonance qui n’intervient que lorsque émetteur et récepteur sonores sont accordés. Cela se produit également pour les phénomènes mécaniques (oscillations forcées) et pourquoi pas pour ces ondes nouvelles ? Faisant éclater une étincelle aux extrémités d’une boucle de fil électrique il constata qu’elle se transmettait à distance sur une autre boucle à condition qu’elles soient de taille égale ou dans des proportions précises.

Quand on lui a demandé à quoi cela servait il a répondu : « A rien ! ». C’était en fait le point de départ de toutes les communications hertziennes « sans fil » y compris la Wi-Fi, le Bluetooth etc.

Marconi : il a tout inventé !

C’est au début du XXe siècle que de véritables progrès ont été réalisés et que des appareils utilisables en pratique ont été conçus, en commençant par les émetteurs à étincelles et, bien entendu, les récepteurs adéquats car les ondes électromagnétiques ne sont pas perceptibles par l’homme. Il a fallu inventer des « interfaces » capables d’influer sur nos sens, essentiellement la vue et l’ouïe. Il a donc été nécessaire de détecter ces ondes autrement que par des étincelles et l’on pense alors au radioconducteur d’Edouard Branly souvent appelé « cohéreur à limaille », mais il y en eut d’autres, en particulier le détecteur électrolytique du capitaine Ferrié. À terme c’est le cristal de galène (sulfure de plomb) qui a remporté les suffrages en raison de sa commodité d’utilisation. La galène est un semi-conducteur naturel, actuellement nous dirions que c’est une diode. On pouvait désormais construire un appareil permettant d’allumer une lumière ou de produire un son dans un écouteur téléphonique.

Comme il s’agit d’un signal par « tout ou rien », un signal binaire, le code Morse s’est imposé de lui-même.

Le grand pionnier de cette époque est sans conteste Guglielmo Marconi qui grâce à un riche mariage avec une Anglaise apparentée au ministre des postes britanniques a bénéficié de fonds très importants pour ses recherches. On peut dire qu’il est vraiment l’inventeur de la TSF « fonctionnelle », en explorant toutes les branches techniques. A la même époque le Kaiser Guillaume II ne voulant pas que son pays soit en retard à largement financé la firme allemande Telefunken. En ont découlé des batailles commerciales féroces telles que Marconi avait interdit aux opérateurs sur les navires utilisant sa radio (comme le TITANIC) de répondre aux appels de détresse de ceux qui étaient équipés du système allemand ! La première transmission transatlantique en 1901 (les 3 points de la lettre « S ») lui vaudra le prix Nobel, contesté par les Américains en 1943 car

Nicolas Tesla aurait déposé le brevet avant lui. Il faut dire qu’à cette époque Marconi était devenu un fasciste largement compromis avec Mussolini.

Et les Français ?

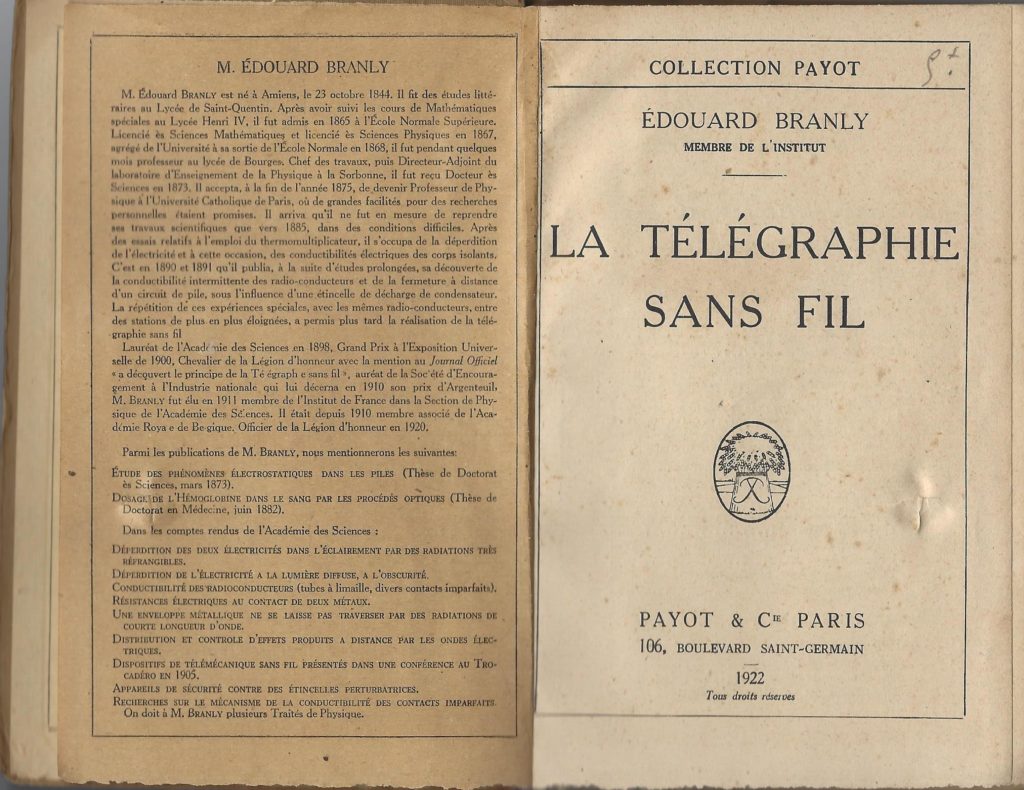

Comme souvent ils sont dès lors en pointe dans la recherche sur les ondes électromagnétiques et leurs éventuelles applications. On pourra citer Edouard Branly pour la radio,

Eugène d’Arsonval pour des applications médicales, Eugène Ducretet l’industriel, mais, hélas, le gouvernement français ne veut pas leur donner les moyens de développer leurs découvertes. Heureusement il y eut quelques hommes d’action, comme Gustave Ferrié, aidé par Gustave Eiffel et le lieutenant de vaisseau Camille Tissot qui se sont donné les moyens de progresser, prévoyant tout l’avenir que ce domaine de recherche allait ouvrir.

Eugène Ducretet fut un génial industriel spécialisé dans la fabrication des appareils de mesure puis il initiera les premières transmissions de la parole. Il s’associera avec le physicien Russe Alexandre Povov et de leur collaboration naîtra un système de télégraphie sans fil équipant 23 navires de la flotte russe.

La première guerre mondiale fera changer les mentalités, favorisant les recherches et les découvertes dans ce domaine bien que l’État-Major ait vivement soutenu au début du conflit l’utilisation des liaisons téléphoniques par fils, régulièrement coupées par les obus de l’ennemi !

Le Général Ferrié et ses sapeurs télégraphistes dans la guerre de 14

En 1904 un Américain, Lee de Forest, avait inventé la lampe amplificatrice triode, un progrès extraordinaire permettant d’amplifier des signaux faibles, mais aussi d’être configurée en oscillateur d’émission. Grâce à Gustave Ferrié, ancien élève de Polytechnique (qui sera nommé général en 1919 ayant débuté la guerre comme capitaine), la lampe TM (triode militaire) deviendra la meilleure du monde.

Grâce à lui, la TSF a gagné ses titres de noblesse au sein des armées. Il a également été le promoteur de la télégraphie par le sol (TPS) qui permet sur de courtes distances (inférieures à 5km) de se passer d’antennes aériennes, cibles privilégiées des artilleurs ennemis, autorisant des communications fiables entre tranchées de première ligne. Ce système utilise l’induction électromagnétique dans le sol. Sa version moderne, le « système NICOLA » permet d’établir des liaisons sans fil avec les spéléologues.

On peut citer pendant cette guerre les écoutes du lieutenant Delavie, né à Vayres (87) et ancien élève de l’Ecole Normale de Limoges. Pendant une année entière il a pu installer des postes espionnant les communications téléphoniques allemandes grâce aux lignes de terre non isolées de l’ennemi.

La radiodiffusion et la modulation d’amplitude

La télégraphie est très utile pour les militaires ou les communications professionnelles, mais pour intéresser l’ensemble de la population il faut passer à la « téléphonie sans fil » et réaliser des « spectacles radiophoniques » pour ainsi dire.

Jusqu’alors on utilisait ce qu’il est habituel d’appeler l’ « onde porteuse » électromagnétique à haute fréquence qui n’est pas audible. On peut la comparer à une voie de chemin de fer : si l’on ne fait pas rouler de train dessus, elle ne sert à rien. Il faut donc MODULER cette onde pour lui faire transporter des sons, et la première façon de faire, celle qui a persisté en France jusque dans les premières années du XXIe siècle et qui est encore utilisée par des stations étrangères : la modulation d’amplitude, l’AM. Comme son nom l’indique elle consiste à faire varier la « taille » de l’onde au rythme de la parole. Le récepteur devra ensuite faire le tri entre l’onde porteuse et l’onde sonore modulante, c’est le rôle de la galène ou de la diode.

La modulation d’amplitude a un inconvénient : comme son nom l’indique on module la puissance du signal contrairement au Morse où l’on envoie toute la puissance de l’onde… ou rien !

A partir de ce principe les techniciens vont améliorer émission (modulation) et réception (démodulation) par divers systèmes ingénieux. La « réaction » (« régénération » disent les Américains) permet d’augmenter le volume sonore et si elle est astucieusement réglée elle permet de recevoir également la télégraphie Morse qui pourtant n’est constituée que par une onde porteuse pure à haute fréquence ! On exploite un défaut causé par une amplification excessive, connu sous le nom d’ « effet Larsen », lors de la sonorisation d’une salle !

Mais il fallait être motivé pour bien se servir de son poste et ne pas craindre d’effectuer de nombreux réglages. De plus, si l’on pouvait augmenter la sensibilité du poste, entendre des émissions faibles, on ne pouvait guère augmenter sa sélectivité, c’est-à-dire la faculté de n’entendre qu’une seule émission à la fois si les porteuses étaient proches en fréquence.

Premier perfectionnement décisif : le système de réception superhétérodyne

Bien que le principe en ait été exposé dans les années 1920 c’est seulement une dizaine d’années plus tard qu’il a été largement mis en œuvre dans les postes « grand public ». Le principe consiste à utiliser le résultat du mélange de plusieurs fréquences. Le signal issu de l’antenne est amplifié puis il est mélangé à celui d’un oscillateur local à fréquence variable pour obtenir un résultat constant, la fréquence intermédiaire (FI ou MF pour « moyenne fréquence »). Ce résultat est possible en modifiant la fréquence de l’oscillateur local en corrélation avec la commande d’accord du poste (recherche des stations ou syntonisation). Cette fréquence intermédiaire (modulée de façon identique au signal capté par l’antenne) est amplifiée puis filtrée. Cela veut dire qu’elle doit traverser plusieurs cellules sélectives à bande passante étroite (deux ou trois en général) éliminant de la sorte toutes les autres fréquences reçues par l’antenne, même celles qui sont proches. Ensuite on détecte l’onde musicale, on élimine la porteuse et enfin on amplifie le son. Bien entendu il s’agit du principe, la mise en œuvre technique n’est pas l’objet de ce document.

Le synoptique d’un poste récepteur sera le suivant :

Capture du signal par l’antenne -> sélection du signal et amplification -> mélange avec la fréquence de l’oscillateur local -> sélection fine et amplification de la moyenne fréquence résultante -> détection de l’onde sonore -> amplification du son et diffusion par le haut-parleur.

Ce principe de fonctionnement est toujours valable même si désormais un ordinateur peut effectuer la majorité de ces opérations. En 1939 les postes récepteurs civils et surtout militaires avaient atteint le maximum de qualité possible. Les transistors puis les circuits intégrés en réduiront le volume mais il faudra attendre les apports de l’informatique de haut niveau pour améliorer la qualité de la réception en particulier sur les émissions faibles et fortement parasitées. Pour cela il faudra numériser le signal et le traiter informatiquement.

La radio militaire, espionnage et ambassades dans l’entre-deux guerres

A la fin des années 30 les armées n’avaient pas toujours de matériel performant et en quantité, surtout l’armée française où l’on croyait encore à la vertu des téléphones de campagne qui pourtant avaient montré leurs limites lors de la Grande Guerre. Or, désormais, on avait affaire à la « Blitzkrieg » où il n’est pas envisageable de poser des lignes téléphoniques pérennes.

En ce qui concerne le renseignement, les ambassades des diverses puissances communiquaient par radio bien que des conventions internationales ne les y autorisent pas, mais personne ne respectait des traités devenus obsolètes. Il y avait des récepteurs très performants mais aucun personnel n’était censé transmettre des informations par la radio. Mais qui empêche un cuisinier d’être en fait un opérateur radio ? Les matériels étaient lourds et volumineux, conséquences de la qualité.

Les postes espions de la guerre de 40

A la déclaration de guerre les Anglais et les Allemands qui souhaitaient envoyer des espions derrières les lignes ennemies, firent le constat qu’ils n’avaient aucun matériel de radio adapté, assez petit et léger pour être transporté et camouflé aisément par un agent secret. Les deux puissances n’avaient jamais eu à faire face à un tel problème dans le passé car l’une et l’autre avaient été des puissances coloniales occupantes bien installées.

Devant l’urgence de la situation il a fallu rapidement imaginer des solutions en acceptant de moins bonnes performances et l’on a pioché dans le savoir-faire des amateurs et régressé en qualité pour gagner en miniaturisation. Cela n’avait pas une importance capitale car il fallait établir des liaisons fonctionnelles et non pas de grande qualité. De plus il fallait obligatoirement utiliser le Morse car on ne savait pas encrypter la parole mais seulement les textes. La télégraphie hertzienne transmettant des lettres sans perte de puissance était toute indiquée pour cet usage. On en est donc revenu aux émetteurs monotubes de faible puissance et aux récepteurs à réaction du début puis, plus tard, des superhétérodynes ont été utilisés.

Au fur et à mesure de l’avancée de la guerre, lorsque les réseaux de résistance alliés se sont mieux implantés il devint envisageable d’utiliser des émetteurs-récepteurs de meilleure qualité mais plus volumineux et plus lourds car les opérateurs n’avaient plus à les cacher ni à les transporter, c’était devenu l’affaire des Résistants, d’où le nom couramment employé de « valises de la Résistance ». Le terme est trompeur, seuls les agents venus de Londres étaient en mesure d’utiliser ces radios qui demandent un long apprentissage et savaient dans quelles conditions et à quels moments il était possible de contacter l’Angleterre. A la fin de la guerre les opérateurs transmettaient des messages qu’ils étaient incapables de déchiffrer, tout le travail ayant été fait par d’autres.

L’arrivée des transistors, la diffusion générale de la radio, la modulation de fréquence, la VHF

Pendant toute la durée de la guerre la radiodiffusion en direction des civils a continué, dans de mauvaises conditions entre propagande allemande, BBC et « émissions culturelles » avec beaucoup de folklore des provinces de France.

A la libération les choses sont revenues petit à petit dans l’ordre, les émetteurs ayant été parfois endommagés et les animateurs occupés à d’autres tâches. La vente de postes de radio a augmenté et les armées se sont dotées de radios nombreuses et performantes. L’armée française a bénéficié de matériels américains dans le cadre de l’OTAN. Même si la fabrication était effectuée en France les appareils étaient produits sous licence américaine. Très souvent il n’y avait que les plaques signalétiques qui changeaient avec l’ajout du suffixe « Fr. » !

En 1948 une révolution technique est apparue : la naissance de nouveaux composants, les transistors, pouvant remplacer les gros tubes et ne nécessitant pas de hautes tensions pour fonctionner. Mais c’est vraiment à partir des années 60 que ces appareils ont remplacé progressivement les anciens postes à tubes. Ils avaient la faveur des jeunes, pouvaient se transporter et gagnaient en mobilité utilisant des piles comme source d’alimentation.

En revanche tous les principes de la radio superhétérodyne sont restés, seuls les montages techniques ont changé pour pouvoir utiliser ces nouveaux composants. Par la suite l’apparition des circuits intégrés contenant de nombreux transistors dans un volume très petit a permis aux postes de devenir minuscules. Il existe depuis de nombreuses années des circuits contenant tous les éléments d’une radio complète dans un seul boîtier minuscule. Tous nos téléphones modernes en contiennent un : un téléphone portable est un émetteur/récepteur de radio à très haute fréquence.

Avec les transistors est apparue une technique déjà connue, la modulation de fréquence ou FM qui a l’avantage de ne pas faire perdre de puissance à l’émission puisque celle-ci ne fluctue plus. En même temps les fréquences radio destinées au grand public ont beaucoup évolué. Les ondes longues

(GO) se situent aux environs de 200 kHz, les moyennes (PO) sont de l’ordre du mégahertz, les ondes courtes (OC) de l’ordre de 10 Mhz et la « bande FM » aux alentours de 100 MHz : les VHF ou very high frequencies. Sur certaines radios anciennes il y a une position « BE » qui signifie « bande étalée ». Cela signifie qu’une étroite portion de bande, généralement en ondes courtes est étalée sur toute la largeur du cadran pour plus de précision en fréquence, agissant telle qu’une « loupe hertzienne ».

Cette élévation des fréquences de transmission a également conduit à une évolution des structures sur le terrain car les VHF ne se propagent pas comme les ondes de fréquences plus basses et nécessitent la présence de réémetteurs de proximité. Il n’est plus question d’ « arroser » un immense territoire avec des stations ayant une puissance monstrueuse. Radio-Limoges qui était un poste régional en ondes moyennes avait une puissance de 100 000 Watts. Une station FM locale dispose de 10 à 20 kW. Un poste émetteur amateur délivre une puissance maximum autorisée de 500 Watts en France, 2 à 3 kW aux Etats-Unis.

La BLU, les radioamateurs, les nouveaux modes de transmission

Bien que le premier brevet pour utiliser la modulation à bande latérale unique (la BLU ou SSB en Anglais) ait été déposé en 1915 c’est après la seconde guerre mondiale qu’elle a vraiment pris son essor essentiellement pour des transmissions utilitaires et pour les radioamateurs. Elle présente les avantages de la télégraphie et de la FM c’est-à-dire qu’il n’y a aucune perte de puissance lors de l’émission. Pour en résumer de manière approximative le fonctionnement c’est de la télégraphie dont la tonalité changerait avec la fréquence de la parole. Un sifflement à 1000 Hz porté par une fréquence HF « f0 » est équivalent à une fréquence télégraphique de « f0 + 1000Hz » (ou -1000Hz, au choix). Le gain en puissance est de 50% par rapport à la modulation d’amplitude.

Pourquoi ne s’en est-on donc pas servi plus tôt ? Parce qu’elle est difficile à mettre en œuvre techniquement pour être de bonne qualité. Un simple récepteur à réaction peut la faire entendre, mais la réception est instable et médiocre sauf si l’émission est très puissante. Nous dirons que c’est « compréhensible », sans plus.

Tous ces modes de transmission radio permettent d’acheminer diverses formes de données. Nous avons parlé essentiellement du code Morse et de la parole mais il existe depuis très longtemps (entre les deux guerres) la transmission d’écrits par « télescripteur » ou « télétype ». Originalement reliés par lignes téléphoniques ces appareils ont été associés à la radio pour devenir des radio-télétypes ou en abrégé « RTTY ». Ces appareils ont été énormément utilisés par les organes de presse et toutes les agences officielles, y compris pendant la guerre de 40. S’agissant de transmission de textes, il est possible de les chiffrer. L’État-Major allemand utilisait la « machine de Lorenz » pour cela.

Ce système existe toujours mais avec les moyens modernes de l’informatique. Les lettres doivent être codées en binaire et affectées d’un numéro selon un code. Le plus ancien est le code Baudot et plus récemment es apparu le code américain ASCII. Le principe de la transmission (on ne peut envoyer que des sons, pas de « bits ») est que le « 1 » est représenté par une tonalité et le « 0 » par une autre.

Il faut également parler du « fac-similé » abrégé en « FAX » pour la transmission d’image fixes. Un des premiers systèmes était le « bélinogramme » du nom de l’ingénieur français Louis Belin, le bélinographe (l’appareil) étant fabriqué par Eugène Ducretet dont il a déjà été question. Il suffisait alors de remplacer les fils téléphoniques par les ondes de radio ce qui fut fait en 1920 grâce au Général Ferrié ! Au début du XXe siècle le monde de la transmission radio était réduit à quelques chercheurs!

L’analyse du document est réalisée par une cellule photo-électrique captant les variations de la lumière reflétée par le document. Au cours de la seconde guerre mondiale, l’armée américaine a produit des « FAXES » de campagne pour transmettre des messages manuscrits ! Le rédacteur devait

les écrire sur une bande calibrée et la machine « lisait » les lettres et les transmettait sous forme de « points » comme les premières imprimantes informatiques.

La radio moderne, numérique, par ordinateur, sur internet

Désormais on peut écouter la radio sur son ordinateur directement via Internet. Ceci est dû à la numérisation des sons, c’est-à-dire au remplacement de la courbe qui représente le signal analogique par une suite de chiffres résultants d’un échantillonnage. Cela signifie que le signal sonore (ou vidéo) est découpé en morceaux et remplacé par une suite de chiffres, chacun équivalant à une tranche ! Il faut que la fréquence du découpage soit largement supérieure à la fréquence du son qui est transformé en une suite de nombres utilisables par un ordinateur. Ce sont les militaires français qui ont été des précurseurs pour encrypter la parole, rendant incompréhensible des conversations « normales » et les restituant à l’arrivée. Dans les années 1980 les Américains ont acheté ce savoir-faire pour leur propre armée.

Dès lors tout fichier numérique peut être traité par l’informatique et il est très commode d’y appliquer les filtres que l’on souhaite, par exemple pour ôter des sons parasites, mais aussi pour jouer un rôle identique aux transformateurs de la moyenne fréquence. C’est la SDR : « Software Defined Radio ». La conséquence en est que la communication est parfaite et en raison de la baisse drastique du prix des ordinateurs celui des récepteurs de radio (et des émetteurs) est également nettement réduit.

Ce nouveau système est aussi important pour la technique radio que le superhétérodyne, comme le stylo à bille l’a été pour l’écriture : c’est une véritable révolution technique !

Un récepteur de radio très performant peut donc être désormais réduit à la taille d’une clef USB connectée à un ordinateur. Les postes modernes des radioamateurs sont eux-mêmes des ordinateurs associés à quelques circuits périphériques pour la réception ou l’émission.

Et que nous réserve demain ?